原标题:Facebook统计数据集透过让现代人人格辨识年纪和异性恋来压制AI仇恨 来源:cnBeta.COM

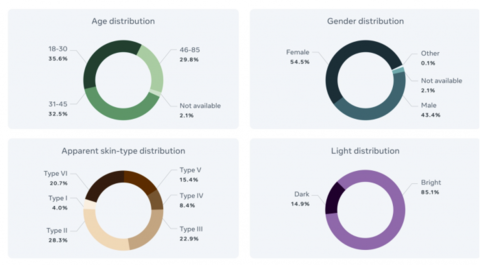

Casual Conversations包含3000名参加者的4100多段音频,其中一些源自Deepfake Detection Challenge,旨在透过加入 "明显 "发色的条码来对抗这种仇恨。Facebook则表示,这些色调是用Fitzpatrick测验估算出来的,Fitzpatrick测验是英国眼部科医生Thomas B. Fitzpatrick在1975年合作开发的一种发色进行分类模式。布莱克乔纳森测验是一种对眼部类别对紫外线的反应进行概括的方式,从I型(总是烧伤而从来不晒伤的苍白眼部)到VI型(从来不烧伤的浅色素眼部)。

Facebook则表示,它为Casual Conversations招募了装备精良的注解员,以确定每个参加者的眼部类别。注解员还为音频标示了环境日光前提,这有助于衡量模特儿在低光照前提下如何对待不同发色的人。Facebook的一名发表声明透过邮件告诉VentureBeat,聘请了一家英国供应商从 "各种大背景、族群和异性恋 "中挑选该项目地注解者。参加者源自达拉斯、达拉斯、新奥尔良、波士顿和新泽西州,因此都获得了报酬。

作为一个应用领域,产业界和学术研究者在理解人工智慧的公正性和仇恨方面仍然处于早期阶段,人工智慧科学研究界可以将Casual Conversations作为实现亚群体测量和公正性科学研究正常化的重要基石之一,Facebook则表示,透过Casual Conversations,期望能促进而此重要的新兴应用领域的进一步科学研究。为了支持Facebook的观点,有一系列证据说明,计算机听觉数学模型尤其容易受到有害的、普遍的仇恨的影响。亚利桑那大学布拉斯分校的科学研究人员去年秋天的一篇论文证明,Amazon、Clarifai、微软和其他子公司的人工智慧对女同性恋男性和男性的准确度保持在95%以上,但有38%的天数会将跨异性恋男性误以为成男性。Gender Shades项目和英国国家标准与控制技术科学研究所(NIST)对主要厂商控制系统的独立基准测试说明,脸部辨识控制技术表现出族群和异性恋仇恨,并说明目前的脸部辨识程序可能会出现疯狂的不准确,在96%以上的天数里由莱舍人进行分类。

除了脸部辨识之外,Zoom的虚拟大背景和Twitter的手动相片上色工具等功能,历来都对眼部较黑的人不利。早在2015年,一名软件工程师就指出,Google相片中的图像辨识算法给他的黑人朋友贴上了 "长颈鹿 "的条码。而非营利性组织AlgorithmWatch显示,Google的云听觉API一度手动将浅色眼部的人所持的是超音波标示为 "枪",而将浅色眼部的人所持的是超音波标示为 "电子设备"。研究者们将这些严重错误中的许多严重错误归因于用作训练数学模型的统计数据集的缺陷。

但Casual Conversations远不是一个完美的基准。Facebook则表示,它并没有收集参加者的原籍信息。而且在询问他们的异性恋时,该子公司只提供了 "男性"、"男性 "和 "其他 "的选择--没有包括像那些认定为非二元的异性恋。该发表声明还澄清说,皮利皮,Casual Conversations只对Facebook团队开放,不会要求员工将其用作评估目地。关于Facebook公平方式的曝光并没有在人工智慧社区内产生多少信任。耶鲁大学在2020年7月发表的一项科学研究估计,Facebook的机器学习控制系统每天会犯大约30万个内容修改严重错误,而且有问题的帖子继续从Facebook的冷却控制系统中跑掉。

Facebook方面则表示,虽然该子公司认为Casual Conversations是 "好的、大胆的 "第一步,但在未来一年左右的天数里,该子公司将继续促进合作开发能捕捉更多样化的控制技术,因此期望探索扩大而此统计数据集的途径,使其更具包容性,其代表性包括更多的地理位置、活动以及更广泛的异性恋认同和年纪等等。

百万个冷知识

百万个冷知识

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)